前段时间ChatGPT的出圈,掀起了新一轮AI技术热潮,也带火了AI大模型。在这种热潮下,算力需求爆发成为一个重要的话题。

根据相关机构的预估,到2030年,全球算力规模将是2021年的28倍,其中智能算力将占总算力的94%,是基础算力总量的16倍。

全新的趋势也引发了新的思考:

· 面对智能算力的爆发式增长,数字基础设施如何满足快速增长的高算力需求?

· 作为算力的支撑载体,数据中心又会面临哪些政策和技术的多项挑战?

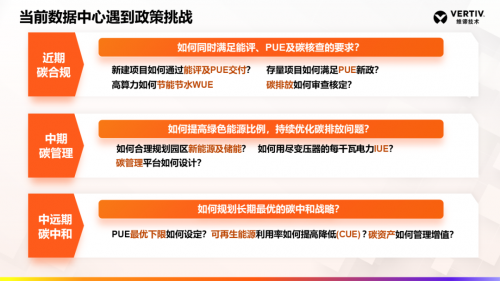

强监管下面临节能节碳挑战

近年来,在“东数西算”工程、数字经济发展、智能计算中心布局的推动下,我国的数据中心保持了20%的持续增长,去年全国平均功率算力比22W/TF,算力增长速度超过了80%。

随着数据中心规模与功率密度的不断提高,其能耗问题日益突出。在数据中心面临的诸多监管中,“东数西算”工程对数据中心的建设标准更为严格。

平均上架率至少要达到65%以上

对PUE的要求也更为严苛

东部数据中心集群平均PUE小于1.25

西部地区平均PUE小于1.2……

与以往不同的是,对数据中心的监管政策开始兼顾碳使用效率(CUE),在强调节能的同时,要求提升可再生能源使用率,减少用水或无水运行,以此驱动数据中心向高智能、高算力、节能节水、低碳环保的方向发展。

PCUE、SPUE技术难题如何寻解

在落实节能减碳之外,为满足AI大模型算力需求,数据中心还要面对如何提高单位算力的难题。化解这个难题,一方面需要提高单柜功率密度,另一方面需要降低功率算力比,用最少的瓦数实现最大的算力。

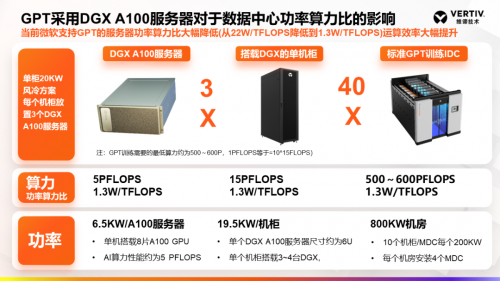

微软通过采用算力性能高达5 PFLOPS的英伟达DGX A100服务器,将单柜功率密度提高了3~4倍。其每个机柜放置3台DGX A100服务器,功率达到20 kW,大幅降低了功率算力比,从22W/TFLOPS降到1.3W/TFLOPS,实现了运算效率的提升。

在微软支持GPT的数据中心中,制冷采用的是风冷解决方案。相对而言,浸没式液冷在安全性、稳定性上还存在一些问题,比如,矿物油易燃、氟化液成本高、元器件与冷却液需要做兼容测试等等,不能有效应对数据中心的高温挑战。

此外,尽管通过在机架上多部署服务器可以解决功率密度问题,但是电力系统占地面积也会大幅激增,最终会面临如何摆放的问题。就此而言,AI大模型算力的发展,在技术层面也对数据中心的功率算力使用效率(PCUE)、空间使用效率(SPUE)提出了挑战。

维谛技术2023关键行动计划

在维谛技术(Vertiv,NYSE:VRT)看来,数据中心所面临的挑战,也代表了绿色关键基础设施可持续发展的六个方向,需要根据不同的发展阶段,制定关键基础设施可持续发展战略。

基于相应的战略,维谛技术(Vertiv)围绕供配电、制冷、管理等维度,在产品、技术层面提供具体的实施路径与落地实践。

近期:通过提供动态在线UPS、全变频氟泵空调、能耗管理等方案,打造超低PUE。

中期:通过提供储备一体化UPS、储能空调、AI节能管理等方案,实现新能源和储能的交付。

中远期:通过提供固态变压器、氢燃料电池发电、热回收装置、碳管理,落地微电网和高密度算力。

目前,维谛技术(Vertiv)基于绿色关键基础设施可持续发展的节碳方向,在2023关键行动计划中,重点聚焦可信超低PUE、PUE节能改造+服务4.0、新能源+储能以及微模块智慧边缘解决方案的交付落地。

AI时代,高算力已经成为大模型应用的关键保障。维谛技术(Vertiv)将以不断的技术创新化解行业挑战,从全生命周期角度打造端到端的绿色低碳数据中心,为AI技术发展夯实算力底座。